В этом году нашему проекту Citation Laureates исполняется 18 лет и, несмотря на то, что присуждение Нобелевской премии будет из-за пандемии проводиться в несколько урезанном формате, для нас игра в предсказание победителей не становится менее интересной: 23 сентября наши списки Citation Laureates пополнились ещё двадцатью четырьмя именами выдающихся учёных.

В чём суть проекта: каждый год с 2002-го мы называем по нескольку фамилий тех учёных, чей вклад в науку тянет на заветную премию, и делаем это примерно за две недели до Нобелевской - которая, в свою очередь, проходит в начале октября. Каждый раз мы обязательно подчёркиваем в наших прогнозах: "это - не прогнозы лауреатов Нобеля на ближайший год", поскольку год присуждения премии предсказать практически невозможно (вот этот текст, который висит прямо в описании методологии).

|

| Citation Laureates не должны считаться буквальными предсказаниями Нобелевской премии конкретного года - методология составления прогнозов |

Логично, что успешным прогнозом является тот, который был сделан с момента старта проекта и впоследствии сбылся. Если говорить на сухом языке цифр, то по состоянию на конец 2019 года в наших списках Citation Laureates числились 336 фамилий (на сегодняшний день - уже 360, все списки доступны публично и абсолютно прозрачны), из них 54 прогноза сбылось, что равняется 16 процентам попадания. Таким образом, каждый год мы угадываем в среднем по три лауреата, и последние годы эта цифра заметно выше среднего - и тем более выше, чем в нулевых годах, когда проект только стартовал.

Методология - совсем вкратце

Что мы хотим показать этим проектом: что есть однозначная корреляция между высокой цитируемостью научной публикации и шансами её автора на получение такой престижной награды. Так, для проекта Citation Laureates мы отбираем все работы в Web of Science Core Collection, которые были процитированы не менее 1000 раз - таких по состоянию на лето этого года было более двадцати тысяч (подробнее о методологии отбора написано здесь - он не ограничивается сухим библиометрическим анализом, наши эксперты вычитывают сами работы и дополнительно анализируют контекст решений Нобелевского комитета).

Но, конечно, не весь этот массив публикаций с зашкаливающей цитируемостью относится к тем направлениям, за которые в принципе можно получить Нобелевскую премию. Собственно, и не каждую номинацию в принципе можно предсказать с помощью библиометрического анализа: разумеется, предсказание лауреатов премии по литературе и премии мира нам пока не по зубам, но оставшиеся четыре направления (физиология и медицина, физика, химия и экономика) - это благодатная почва для предсказаний при помощи Web of Science.

О том, какие учёные - и за какие заслуги - попали в наши списки Citation Laureates в этом году, я предлагаю вам почитать на странице проекта. В этом посте я хочу напомнить о самых интересных российских фамилиях, которые были в наших предыдущих прогнозах, но которые заслуживают гораздо большего внимания за несколько дней до Нобелевской недели.

За кого нам "болеть"?

В первую очередь, это два известных учёных, синхронно попавших в наши списки три года назад: это ведущий научный сотрудник Института химической физики (ИХФ) им. Н. Н. Семёнова РАН Георгий Борисович Шульпин и главный научный сотрудник Института космических исследований РАН, (а также - директор Института астрофизики общества Макса Планка) Рашид Алиевич Сюняев.

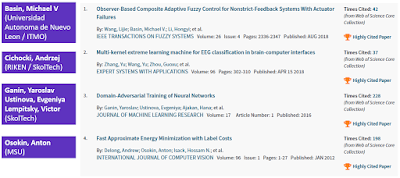

В 2017 году коллеги предсказали, что Георгий Шульпин должен получить Нобелевскую премию по химии - вероятнее всего, совместно с Джоном Беркоу из Калтеха и Робертом Бергманом из Беркли - за вклад в функционализацию углеродно-водородных связей. Можем ли мы оценить, как этот вклад измеряется сухим языком библиометрии? Нет проблем - вот публикация Георгия Борисовича, сделанная в декабре 1997 года - по состоянию на 28 сентября 2020 она собрала в Web of Science Core Collection аж 2339 цитирований, все изображения кликабельны.

|

| Публикация 1997 года "Activation of C-H bonds by metal complexes" Георгия Борисовича Шульпина в Chemical Reviews и её цитируемость на конец сентября 2020 г |

Рашид Сюняев (ссылка на сам прогноз - та же, что и у Георгия Борисовича), как мы считаем, должен получить Нобеля по физике за его "глубокий вклад в наше понимание Вселенной, включая ее происхождение, процессы образования галактик, дисковую аккрецию черных дыр и многие другие космологические явления". И действительно - в Web of Science Core Collection без труда можно найти 8 публикаций Рашида Алиевича с цитируемостью больше 1000, некоторые из которых сделаны в рамках крупных коллабораций вроде Planck Collaboration, но, пожалуй, наиболее важная из них по праву находится в самом верху списка с 9293 цитированиями. Именно она долгое время являлась наиболее цитируемой отечественной публикацией в Web of Science Core Collection, пока в начале десятых годов её не обогнала... "Electric field effect in atomically thin carbon films", "нобелевская" работа Андрея Гейма, Константина Новосёлова и других известных соавторов.

|

| Публикация 1973 года "Black Holes in Binary-Systems - Observational Appearance" Рашида Сюняева в журнале Astronomy & Astrophysics и её цитируемость на конец сентября 2020 г. |

Здесь я вынужден оговориться - конечно же, Нобелевскую премию присуждают не за конкретную статью, а за вклад в науку. Я привожу здесь лишь наиболее цитируемые публикации из соображений экономии места, поскольку не нашёл способа вставить в blogger удобочитаемый скриншот на 8 и более публикаций из Web of Science Core Collection

И ещё три интересных фамилии

Если как следует покопаться в списке Hall of Citation Laureates, в котором представлены все учёные, попадавшие в наши прогнозы с 2002 года, то можно найти ещё как минимум троих человек - увы, уже без российской аффилиации, но всё же с российскими или советскими корнями. Если пока вы не слышали этих фамилий, то вдвойне рад представить вам их.

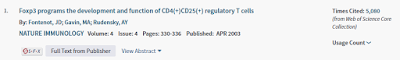

Александр Юрьевич Руденский - директор Людвигского центра иммунотерапии рака в Мемориальном онкологическом центре Слоуна-Кеттеринга в Нью-Йорке. Вот ссылка на наш прогноз 2015 года - "за открытия, связанные с регуляторными Т-клетками". По состоянию на конец сентября 2020 Web of Science Core Collection видит 7 работ Александра Юрьевича с цитируемостью более 1000 (и, по всей видимости, скоро их будет уже 8), и тут особняком стоит вот эта.

|

| Публикация 2003 года Александра Руденского в Nature Immunology и её цитируемость на конец сентября 2020 г. |

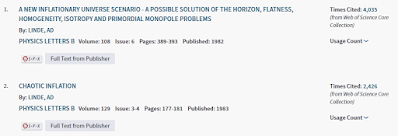

Андрей Дмитриевич Линде - профессор Стэнфордского университета. Его награждение мы предсказывали аж в 2006 году. У Андрея Дмитриевича 5 публикаций в Web of Science Core Collection с цитируемостью, превышающей заветную планку, но интересно, что две самые цитируемые написаны им ещё в "достэнфордский" период научной карьеры и содержат только одну аффилиацию - это ФИАН.

|

| Две из пяти наиболее цитируемых публикаций Андрея Линде в Physics Letters B и их цитируемость на конец сентября 2020 г. |

Last but not least, Валерий Валерьевич Фокин. Предсказание было опубликовано в 2013 году с мотивировкой: "за развитие молекулярной клик-химии" (2013 год, надо отметить, был удачный на сбывшиеся прогнозы: именно тогда нами был предсказан Петер Хиггс, а также лауреаты 2019 года Мишель Майор и Дидье Кьело). Тогда основной аффилиацией Валерия Валерьевича был Институт Скриппса, но с 2015 года он работает в Университете Южной Калифорнии - что и подтверждается его аффилиациями в научных статьях. А вот и самая цитируемая из его публикаций (всего с цитируемостью более 1000 у него их сейчас тоже, как ни странно, 8).

|

| Наиболее цитируемая публикация Валерия Фокина и её цитируемость на конец сентября 2020 г. |

Резюмируя вышесказанное: фамилии, появившиеся в нашем списке Citation Laureates в прошлую среду - безусловно, выдающиеся учёные, сделавшие огромный вклад в современную науку, но часто хочется искренне желать победы кому-то более родному. И если принцип support your local team русскому человеку близок, то пусть эта local team в контексте Нобелевской премии состоит из фамилий Шульпин, Сюняев, Руденский, Линде и Фокин.

И всё?

Если эта история с прогнозами вам интересна, приглашаю вас посоревноваться в их точности - как я написал в самом начале, по состоянию на конец прошлого года она составляла у нас 16%. Нас иногда спрашивают - а есть ли у вас конкуренты в этом деле? Конечно, нельзя в шутку не упомянуть мультсериал "Симпсоны" и их эпизод Elementary School Musical, которые, если отбросить опечатку в имени Веры Рубин и того факта, что Оливер Вильямсон - не физик, а экономист (хотя, надо признать, впоследствии тоже получил Нобелевскую премию), идут с нами примерно вровень.

Конечно же, никто из нас не может знать наверняка, фамилии каких российских учёных могут быть на радаре у Нобелевского комитета прямо сейчас. Но смотрите, какое интересное упражнение можно сделать, если у вас будет соответствующий интерес и пара часов свободного времени:

1. Провести поиск в Web of Science Core Collection по всем публикациям России и СССР с типом документа "article" или "proceedings paper" за период с 1970 года

2. Отсортировать их по количеству цитирований

3. Исключить из результатов поиска мегаколлаборации

4. Остаётся чуть меньше 200 публикаций с более чем 1000 цитирований

Планка в 1000 цитирований - скорее психологическая, чем библиометрическая, но 200 оставшихся в результате документов - это не big data, их можно потрогать руками и посмотреть, кто их автор и почему они так хорошо цитируются. Кто знает, возможно, вам удастся таким образом найти российских авторов, не попавших в наши прогнозы, но чьё имя может прогреметь через неделю в Стокгольме.